安全文化

安全文化という用語は、チェルノブイリ原子力発電所事故を契機として、IAEAがINSAG-1にて用い始めたとされます(赤塚 2009、西田 2017)。当初IAEAは用語の定義をおこないませんでしたが、その後、INSAG-3にて、安全文化を、原子力発電所の安全性に関わるあらゆる活動に従事するすべての個人の献身と説明責任と定義しました。

安全文化は、組織文化の下位概念として位置づけられ、安全に関する価値、信念、態度、仮定、規範であって、職位にかかわらず組織全体で共有あるいは共通のもので、個人や組織の行動や意志決定、安全管理制度のあり方に影響を及ぼすものとして、多く定義されます(赤塚 2009)。

Reason,J.T(1997)は、安全文化を構成する要素として、報告する文化、公平な文化、柔軟な文化、学習する文化を上げています。

Reason,J.T.(1998)によれば、安全文化は、情報文化ともいう事ができます。情報文化とは、端的に言うと、人々が、あらゆるレベルで怖がる事を忘れない文化です。安全が確保された気危険な作業では、事故の起こる確率が下がります。そのような状況で警戒心を持続させるたった一つの方法は、事故に関する情報を収集、分析し、その普及をはかる安全情報システムをつくることです。そのためには、まず、報告する文化を作り出す必要があります。しかし、報告する文化を作り出すことは、自分のミスを報告する場合には、特に難しくなります。そこで、報告者の身元が確認できないことや、情報収集機関と制裁を課す権限を持つ機関とをわけること、報告しやすくすることなどが有効とされますが、最も重要な要素は信頼であり、それを得るためには公正な文化を作り出す必要があります。つまり、報告する文化を作るためには、公正な文化が必要です。あらゆる種類の行動を許容する文化は、信頼性に欠けます。安全でない行動の一部、特にコンプライアンス違反や薬物の乱用といった、安全でない行動のごく一部は制裁に値するもので、そうすることで、職場環境はより安全になり、組織がより公正であると認識される可能性が高くなります(Reason,J.T. 1998)。

また、通常は従来通りの階層的な方法でコントロールされているものが、緊急事態ではその場の専門家にコントロールが移行し、危機が去るとまた通常のコントロールに戻る、といった柔軟性は、システムの重要な安全装置のひとつでもあります(Reason,J.T. 2000)。

学習する文化とは、安全情報システムから正しい結論を導き出す意欲と能力、および必要性が示されたときに大規模な改革を実施する意志を持つことです(Reason,J.T. 1997)。Reason,J.T.(1997)は、これら4つの文化が相互に作用することで、情報文化が形成されるとしています。

事故を防止するには、事故要因を分析する必要があります。事故要因の分析には事故モデルが利用されます。事故モデルには様々なものがあり、福岡(2017)は、先行研究をもとに、代表的な事故モデルを、連続的事故モデル、疫学的事故モデル、システミック事故モデルに整理しなおしています。

連続的事故モデルは,Heinrich,H.W.の提唱するドミノ理論が代表とされドミノ・モデルとも称されます(福岡 2017)。Heinrich, H.W.(1941)は、事故が発生する一連の流れはドミノ倒しに例えることができるとしました。具体的には、遺伝と環境が、無謀、短気、神経質、興奮しやすい、思いやりがない、安全対策を知らないといったその人の欠点を引き起こします。そして、そのような人の欠点は、吊り荷の下に立つ、警告なしに機械を始動させる、悪ふざけ、安全装置の取り外しといった安全でない行為や、ギアが保護されていない、操作をする場所が保護されていない、レールガードがない、不十分な明るさの照明などといった機械的物理的な危険性の要因となります。それら安全でない行動や機械的・物理的な危険は、直接事故に結びつき、怪我をもたらします。このように一つの要因が次の要因の呼び水となって事故が起き、傷害に至ります。そのため、この一連の流れを構成するいくつかの要因のうち、1つでも取り除かれれば、傷害は発生しないとします。

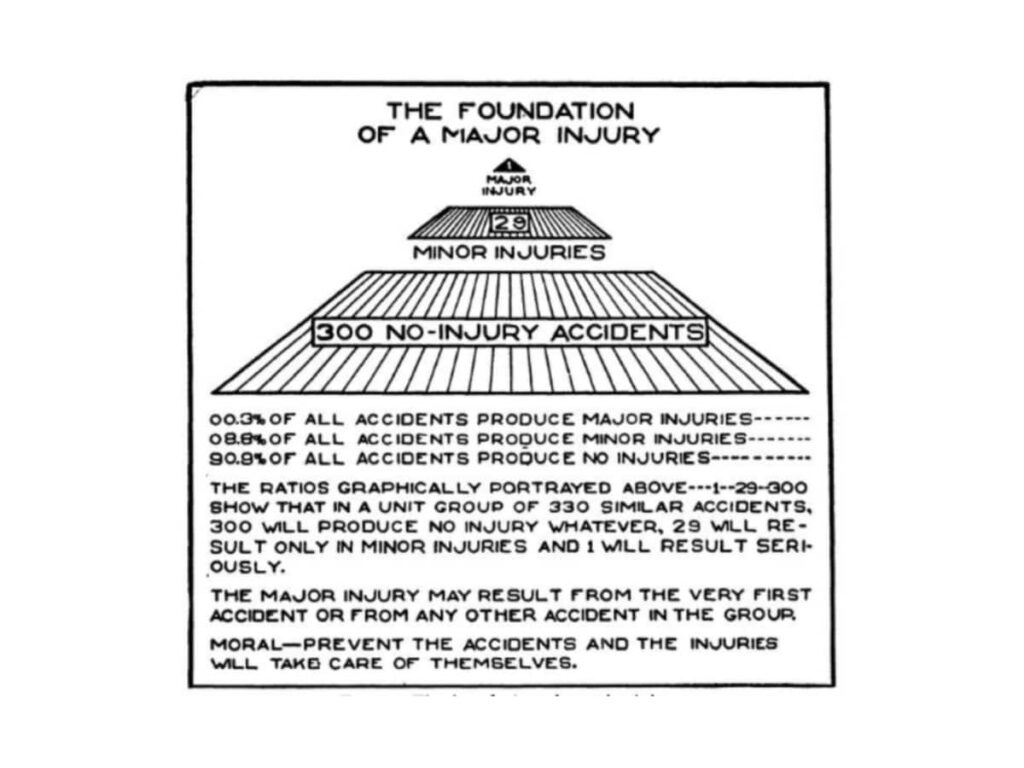

またHeinrich, H.W.(1941)は、怪我に至るような事故があれば、怪我に至らないような事故もあり、同じ種類の事故330件のうち、300件は無傷、29件は軽傷、1件は重大なまたは休業に至る怪我になることも示しています。このいわゆるハインリッヒの法則は、事故が起きなくとも事故につながりそうなミスや事象にヒヤリとしたり、ハッとしたりして気づく、いわゆるヒヤリ・ハットを収集する根拠となっています(佐々木・原田 2014)。

図 ハインリッヒの法則 (Heinrich, H.W. 1941)

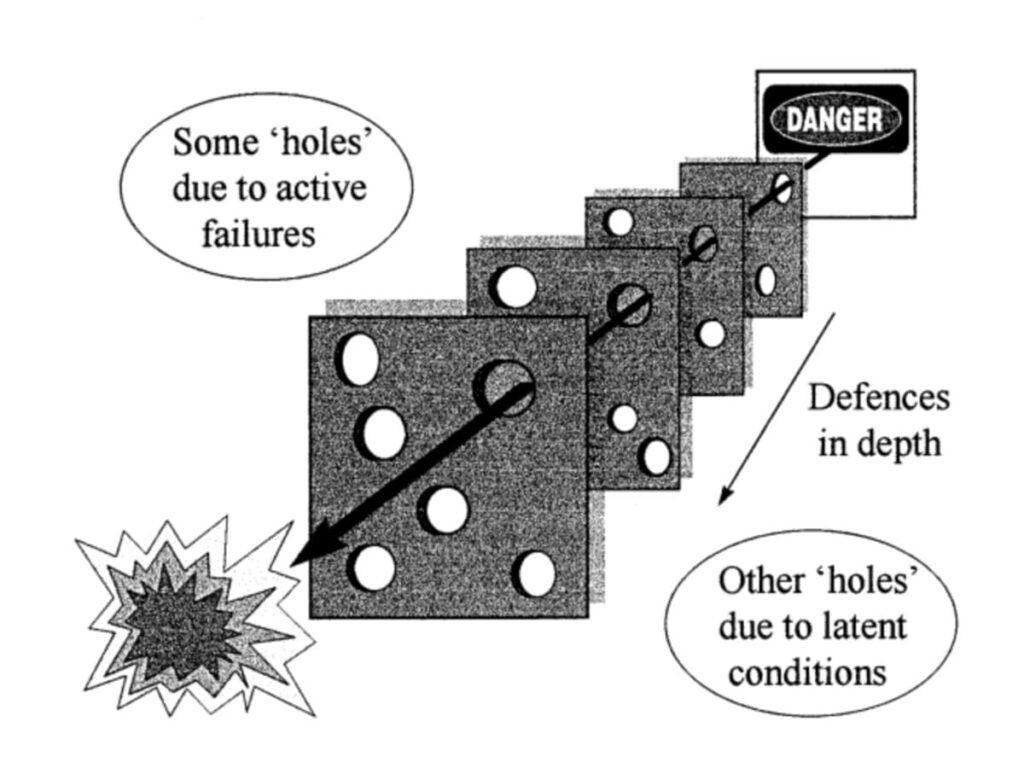

しかし、その後の事故を調査する中で連続的事故モデルの限界が指摘されるようになり、疫学的モデルが提唱されるようになりました。疫学的事故モデルの代表は、Reason,J.T.のスイスチーズモデルです。Reason,J.T(1997)は、事故の起きる過程について、スイスチーズを比喩として用いています。スイスチーズモデルでは、事故を予防するための複数の層を仮定します。理想的には、それらの各層によって危険は防がれ事故は起こらないはずですが、現実的には穴が開いており、それら複数の層に空いている穴を危険が通り抜けることで事故が起こるとします。このスイスチーズモデルの穴は、パイロットや航空管制官、警察官などによって、「システムの先端で」おこなわれるエラーや違反行為である即発的な失敗(active failures)と、設計の不備、監督の不行き届き、製造上の欠陥やメンテナンスの失敗といった潜在的な条件(latent conditions)によって、できたり閉じたり、広がったり縮んだりする流動的なものです。

図 スイスチーズモデル(Reason,J.T 1997)

さらに研究が進む中で、疫学的事故モデルでは通常の人がふだんと同じ作業を行っているときに発生する事故を説明することができないことを理由に、システミック事故モデルが発展していきます。システミック事故モデルでは、事故が起きる原因と結果のリンクを排除して社会技術システムを構成する要素すべてに焦点を当て、各要素の相互関係に問題が生じたときに事故が起きるとしています。

関連問題

●2022年-問50 ●2019年-問29 ●2018年(追加試験)-問123

参考・引用文献

- 赤塚肇 2009 組織安全アプローチにおける安全文化と安全風土-両者の差異について- 産業教育学研究39(2) 31-38

- 福岡幸二 2017 事故モデルの動向と各産業に適用できる事故モデル 労働科学93(2) 48-60

- Heinrich, H.W. 1941 Industrial Accident Prevention A Scientific Approach. Second Edition. McGraw-Hill, New York

- Hollnagel E, Speziali J. 2008 Study on Developments in Accident Investigation Methods A Survey of the State of the Art, SKI Report 2008:50. Stockholm Swedish Nuclear Power Inspectorate.

- International Nuclear Safety Advisory Group 1986 summary report on the post-accident review meeting on the chernobyl accident. INSAG-1, Vienna International Atomic Energy Agency.

- International Nluclear Safety Advisory Group 1988 basic safety principles for nuclear power plants. IAEA Safety Series No.75-INSAG-3, IAEA, Vienna

- Reason, J. 1997 . Managing the risks of organizational accidents. Ashgate Publishing.

- Reason,J. 1998 Achieving a safe culture theory and practice Work and stress 12(3) 293-306

- Reason,J. 2000 Human error models and management BMJ, 320(7237) 768–770.